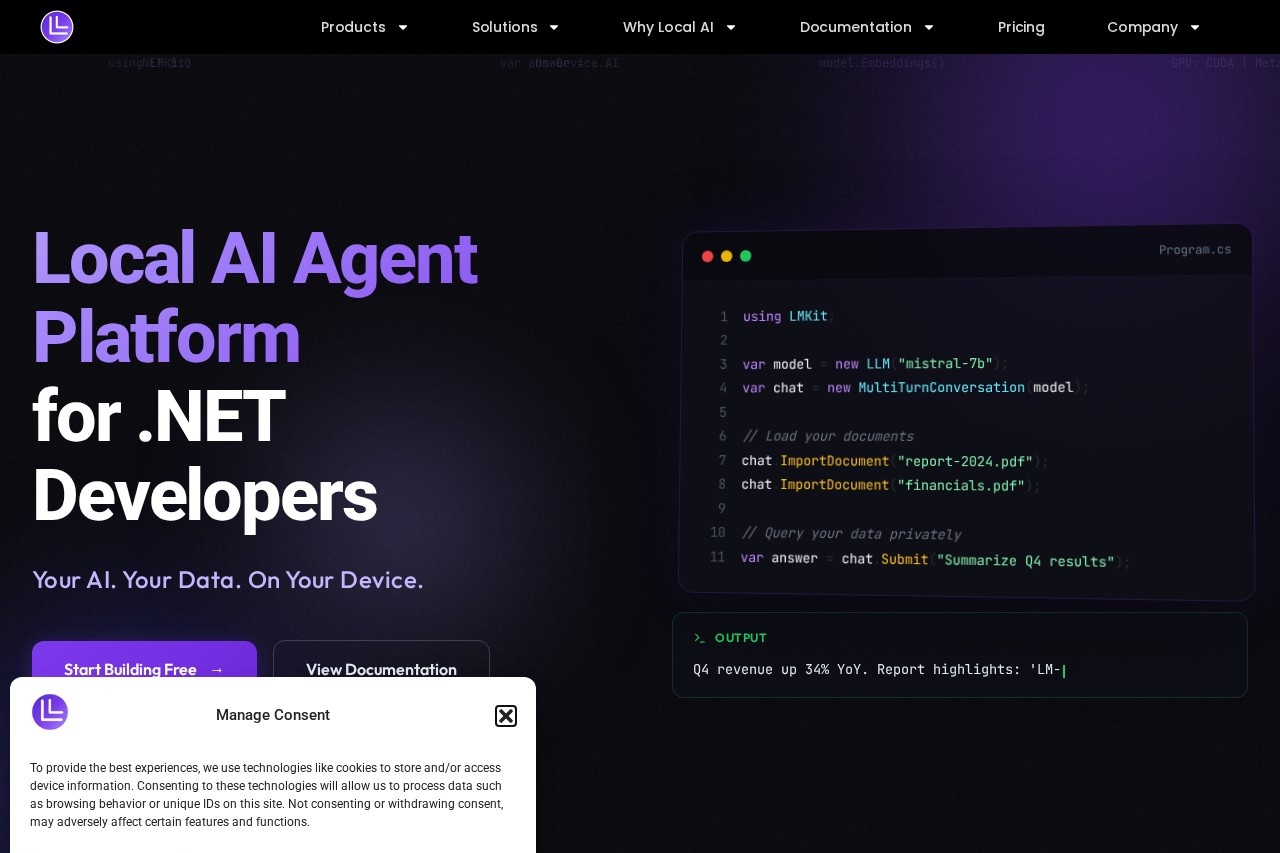

LM-Kit

综合介绍

LM-Kit是一个专为开发者设计的本地AI平台。它让你能在自己的电脑上运行大型语言模型(LLM),无需依赖云端服务。这个工具特别适合需要保护数据隐私的开发团队或个人。

平台提供了AI代理编排功能,可以轻松组合不同AI模型来完成复杂任务。所有计算都在本地进行,数据传输零延迟,响应速度比云端服务快很多。

LM-Kit最大的特点是完全由用户控制。你不用把敏感数据上传到别人的服务器,所有操作都在自己的设备上完成。这对于医疗、金融等需要严格数据保护的行业特别有价值。

功能列表

- "本地LLM运行":支持多种开源大语言模型在本地设备上运行

- "AI代理编排":可视化工具帮助组合多个AI模型协同工作

- "隐私保护":所有数据处理都在本地完成,不上传任何数据

- "快速响应":省去网络传输时间,获得即时计算结果

- "应用构建":提供API和开发工具包,方便集成到现有系统

使用帮助

LM-Kit安装过程很简单,只需三步:

- 从官网下载适合你操作系统的安装包

- 运行安装程序,按照提示完成安装

- 第一次启动时会自动下载必要的模型文件

安装完成后,你会看到简洁的主界面。左侧是功能导航,中间是工作区。

要运行第一个本地AI模型:

- 点击"模型管理",选择要使用的语言模型

- 等待模型加载完成(首次使用需要较长时间)

- 切换到"交互"标签页,输入你的问题或指令

- 点击发送按钮,立即获得AI的本地响应

创建AI代理工作流:

- 进入"代理"页面,点击"新建"按钮

- 从右侧面板拖拽需要的AI组件到工作区

- 用连接线定义组件间的数据流动

- 保存工作流,以后可以随时调用

开发隐私优先应用:

- 使用内置的API测试工具调试接口

- 查看文档了解如何集成到你的代码中

- 所有数据都保留在你指定的本地路径

产品特色

完全本地运行的AI开发平台,保护数据隐私同时提供零延迟体验。

适用人群

- 开发者:需要本地AI能力的软件工程师

- 企业IT团队:处理敏感数据的内部技术团队

- 研究人员:需要保护实验数据的学术工作者

应用场景

- 内部知识管理:构建不依赖云端的智能文档系统

- 医疗数据处理:安全分析患者病历和检查报告

- 金融风控:本地运行敏感财务数据分析模型

常见问题

- 需要什么样的硬件配置?

建议至少16GB内存和独立显卡,具体取决于模型大小。 - 支持哪些AI模型?

支持大多数开源LLM如Llama、Mistral等,持续更新中。 - 能不联网使用吗?

完全可以,所有功能都设计为离线使用。